چالش هاي معنوي و اخلاقي هوش مصنوعي

چندين دهه است كه مباحث اجتماعي و انساني درباره هوش مصنوعي ، سازمان ها و افراد مشتاق و پيگير اين مقولات را به خود مشغول داشته است ، اكنون ديگر هيچ دليلي وجود ندارد كه ماشين هاي هوشمند و روبات هايي كه در پيشگويي ها و داستان هاي علمي تخيلي پرطرفدار بين سالهاي اواخر قرن نوزدهم تا دهه 1960 وجود داشتند ، به وجود نيايند. ما در همان آينده تخيلي زندگي مي كنيم ، عصر طلايي تكنولوژي را تجربه مي كنيم و در چشم اندازمان هيچ محدوديت و غايتي متصور نيست .

شايد در وهله اول مقوله «كار» باشد كه نياز به هوش مصنوعي را برجسته مي كند و از سه جنبه نظرات مطروحه در اين باره و ملزومات اخلاقي و معنوي آنها را مي توان دسته بندي كرد. نخست آن كه وقتي بخشي از ما انسان ها در تنگدستي و بيكاري به سر مي بريم دليلي وجود ندارد كه كارگران مكانيكي ( آن هم به صورتي كه قادر به تفكر مستقل باشند ) توليد شوند، گذشته از آن كه در چنين حالتي امكان آن كه همان كارگران مكانيكي اما در اين باره با انسان ها به بحث بنشينند ، وجود دارد !

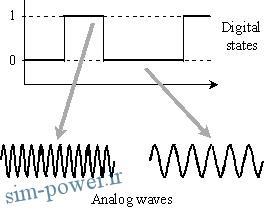

گروهي ديگر استدلال مي كنند كه جامعه نمي تواند بودن هيچگونه استعانتي از ماشين هاي هوشمند ، پيشرفت شايسته اي داشته باشد . گروه سوم هم چندان درگير مسئله نمي شوند و آن را بحث اچتماعي پيش پا افتاده اي بيش نمي دانند. در سطحي خردنگرانه تر در مورد حد و گسترة ساخت ماشين هاي هوشمند و اينكه اين ماشين ها بايد شبيه چه چيزي باشند هم اختلاف نظرها نمايان است . كما اينكه با هر يك از رويكردهاي فوق به سراغ ماشين هاي هوشمند رويم اين سئوالات پاسخ ها و تحليل هاي مختلفي خواهند يافت . ساختار و عملكرد مغز انسان حاصل ميليون ها سال بقا و رفتار اجتماعي است و ما هنوز هم در اين پروسه تكاملي قرار داريم . تقليد از عملكرد مغز چالش بزرگي در دنياي هوش مصنوعي است و اگر مبناي قضاوت ، قدرت و پيچيدگي پردازنده هاهي موجود باشد ، بايد اعتراف كرد كه هنوز چندين دهه تا رسيدن و شبيه سازي بسيار ابتدايي هوش انساني راه مانده است .

از ديگر سوي اگر ما خواستيم و توانستيم كه روبات هاي انسان نما (robots android) را چنان خبره طراحي كنيم كه با ما به رقابت برخيزند، هنوز اين پرسش به قدرت خود باقيست كه كدام ارزش هاي معنوي و اخلاقي را بايد به آنها تزريق كنيم ؟ يعني با توجه به ناهمگوني هاي عميق فرهنگي ، ديني ، اخلاقي و معنوي تمدن بشري ، قبل از ساخت هر روباتي دقيقاٌ بايد بدانيم براي كجا و به چه منظور ساخته خواهد شد. براي مثال آيا بايد ما روبات هايي بسازيم كه اعتقادات ديني خاصي داشته باشند ؟ مثلا آدم آهني هايي توليد شوند كه كاتويك ، مسلمان يا بودايي باشند ؟ يا حتي در حالتي ظالمانه مثلاٌ كاپيتاليست باشند تا بهره وري افزون شود ؟

به همان ميزان كه تعريف و جداسازي آن مفاهيم بشري مشكلند ، تزريق جداگانه و درعين حال مركب آنها به يك ماشين « هوشمند » نيز سخت و صعب است . افزون بر اينكه تعيين نحوه كاربرد اين ارزش ها هم پرسشي ديگر است . مثلا اگر مجموعه اي از ارزش هاي معنوي و اخلاقي مرگ خودخواسته يك بيمار لاعلاج (euthanasia) را روا دانست و مثلا اگر مجموعه اي ديگر از ارزش هاي مشابه آن را نهي كرد ( همان حالتي كه در مغز يك انسان به راحتي اتفاق مي افتد ) چه راهي توسط يك مصنوع هوشمند در پيش گرفته خواهد شد ؟ مبنا كدام است ؟ البته مي توان چنين ناهمگوني اي را در راهي توسط يك مصنوع هوشمند در پيش گرفته خواهد شد ؟ مبنا كدام است ؟ البته مي توان چنين ناهمگوني اي را در افكار و اعمال بشري نيز سراغ كرد. اما وقتي ناهمگوني هاي بشري اينقدر زياد و دردسرساز است چه لزومي دارد كه درگير ناهمگوني هاي مشابه هوش مصنوعي شويم ؟

آيا به اندازه كافي مشكلات بيولوژيكي در اين زمينه نداريم ؟ يا مي خواهيم دقيقاٌ آدم بسازيم و خدا بشويم ؟ اصلاٌ آيا منظور ما از خودمختاري يك ماشين چيزي نظير فضاپيماهاي بي سرنشين است يا روباتي را در ذهن مي پرورانيم كه انديشه و ظاهر و كردار آدمي را تقليد مي كند ؟ و بعد هم درنظر داريم همگام با جامعه اي كه هر روز « خودكار » تر مي شود، فرزندانمان ، موسسات آموزشي ، تجارت و حتي دولت ها را به دست اين ماشين هاي معرفت دار بسپاريم ؟

پاسخ ها در اين زمينه روشن نيست . تحيقات بر روي جنبه هاي گوناگون هوش مصنوعي گسترده و ضمناٌ متمايزند، در حالي كه ما حتي در مورد تعريف دقيق «هوش» هم به توافق نظر نرسيده ايم ، در پي ساختن «مصنوعي» بدهد ؟

اما اگر ما بتوانيم ماشين هاي انسان نما را چنان هوشمندانه طراحي كنيم كه رفتاري نظير انسان ها از خود بروز دهند ، چه الزامي هست كه آنها براي هميشه تابع و فرمانبر ما بمانند ؟ ايساك آسيموف نويسنده داستان هاي علمي تخيلي كه به خاطر داستان هاي روباتي خود مشهور است ، سه قانون را براي مغزهاي پوزيتروني روبات هايش ارائه داد تا انسان ها در مقابل « انقلاب روبات ها » و همچنين جلوگيري از سوء استفاده ديگر انسان ها از رباتها محافظت شوند :

– يك روبات نبايد به انسان آسيب برساند يا با كاهلي خود باعث آسيب ديدن انسان شود.

– يك روبات بايد از دستوراتي كه انسان ها به او مي دهند اطاعت كند، مگر آنكه مستلزم نقض قانون اول باشد.

– يك روبات بايد وجود خود را تا زماني كه با قوانين اول و دوم تضادي نداشته باشد، حفظ كند.

در سطحي كاربردي تر ، اگر ما بتوانيم مصنوع هوشمندي را در قالب انسان نما با ماشيني به صورت وجودي خنثي بسازيم و في المثل صرفاٌ جهت تدريس به كار گيريم باز در چنين حالتي هم مشكلات وجود دارند چه آنكه گرچه موضوعاتي هستند همانند جغرافيا يا مهارت هاي فني كه شايد مستلزم هيچ ارزش معنوي ، اخلاقي ، يا ديني به ناچار نيستند اما باز هم روبات ها با آنها مشكل دارند ، مثلا اگر قرار باشد يك روبات اين مقولات را هم تدريس كند، از طرف بچه ها با چنين پرسشهايي روبه رو خواهد شد: « بله … درست است ، اما چرا ؟ » در چنين حالتي چه واكنشي يك روبات خواهد داشت ؟ آيا بايد پيغام هايي چون « غيرقابل محاسبه » يا « اين سئوال تعريف نشده است » يا « چرا سئوال معتبر نيست ؟ لطفاٌ دوباره طرح كنيد » . تحويل يك دانش آموز داد ؟ چگونه مي توان به چيزي اعتماد كرد كه در مقابل پرسش «چرا» خلع سراح مي شود و هرگونه واكنش غيرقابل پيش بيني در مقابل هرگونه كنشي كه مستلزم پردازش پرسش هاي مداوم چرا و چگونه باشد از آن محتمل است ؟ پرسش هايي از اين دست فراوانند و هر تفكر و تاملي در مورد هوش مصنوعي مي تواند آنها را توليد و بازتوليد كند، تصميم با شماست .